搜索引擎收录并不是什么都收录最好,而是收录比较质量的页面比较好,那将会让你的网站看起来更质量,相反收录太多垃圾或是无用页面则会带来负面的影响,比如会分散权重,降权之类的,所以我们应该禁止蜘蛛抓取这些页面

看问题

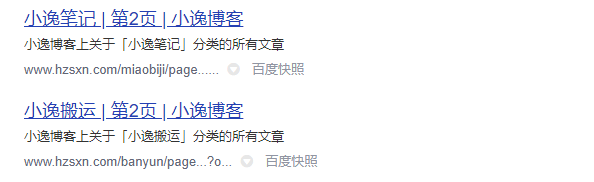

先看下问题,百度这边收录了我的标签页的分页面,基本这类的收录小逸个人认为没什么价值。而且会分散网站的权重

找方法

我们只需要屏蔽掉蜘蛛抓取这些页面就可以解决这个问题,那我们应该如何屏蔽蜘蛛呢?

robots

Robots是站点与spider沟通的重要渠道,通过robots文件声明本网站中不想被搜索引擎收录的那部分或者指定搜索引擎只收录特定的部分。

robots.txt文件必须放在网页的根目录,蜘蛛抓取的时候会先检索跟目录下有没有robots.txt,如果有蜘蛛将会遵守规则对站点进行抓取

本站的robots文件:https://www.scczz.com/robots.txt

屏蔽掉分页需要加上

Disallow: /*/page

Disallow: /*/*/page

百度关于robots的书写教程和简介https://ziyuan.baidu.com/college/courseinfo?id=267&page=13

如果有更好的办法欢迎评论指出噢!

还没有人赞赏,快来当第一个赞赏的人吧!

- 2¥

- 5¥

- 10¥

- 20¥

- 50¥

声明:本文为原创文章,版权归小王总博客所有,欢迎分享本文,转载请保留出处!